在10月份,浙江大学一个研究团队把成果发在了《自然・人类行为》上。

这篇论文没讲别的,就说一件事:ChatGPT这类大型语言模型(LLM)处理句子的方式,跟人类大脑的认知模式特别像。

之前我总觉得AI就是“按数据出牌”,只会匹配现成的语言模式,真没料到它能在认知层面跟人类靠这么近。

本来想先绕绕圈子讲讲AI语言研究的背景,但后来发现没必要这研究最打动人的就是“直接”,所以咱们也直接切入正题。

它解决了一个老难题:以前想对比人类和AI的语言处理方式,总因为两者本质差太远而卡壳,这次浙大团队用一个巧妙的实验,把这个坎迈过去了。

372人PKChatGPT:一场“删单词”比赛测出认知秘密

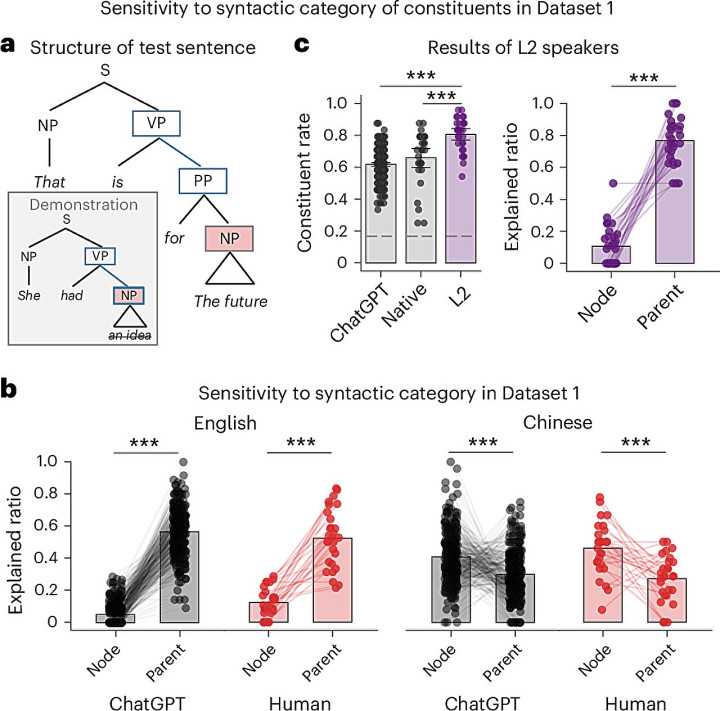

研究团队搞了两个核心任务,先说说第一个“单词删除任务”。

他们找了372个人,这些人里有说中文母语的、说英语母语的,还有会两种语言的。

然后让这些人和ChatGPT一起做一件事:给句子“瘦身”,删掉一些词但不能破坏核心意思。

结果出来的时候,我还挺意外的。

不管是人还是ChatGPT,删词的时候都不瞎删专挑完整的语法成分下手,比如删PP短语(像“在桌子上”)或者NP名词短语(像“红色的苹果”),不是随便揪着哪个词就删。

更有意思的是,用中文的时候就按中文语法删,用英文的时候就按英文语法删,两者的节奏能对上。

还有个“一次性学习任务”,这个更考验“直觉”。

参与者先看一个示例,自己琢磨出删词的规则,再把规则用到新句子上。

这时候不用靠之前学过的知识,纯看对语言结构的敏感度。

很显然,ChatGPT没掉链子,它的表现跟人类参与者还是很同步。

研究里还有个细节特别关键:研究人员根据人或者ChatGPT删掉的词,能还原出句子的“句法树”就是句子里各个成分的结构关系。

这说明啥,说明两者处理语言的时候,都在跟着同一种底层的句法规则走。

这一点比单纯的删词重合更有说服力,毕竟句法树是语言理解的“骨架”,AI能跟上这个骨架,就不算只停留在表面了。

当然,也不是说两者完全没差别。

比如不同语言背景的人,删词策略会不一样中文使用者更在意语序,英文使用者更盯着时态。

但有意思的是,只要在同一种语言环境里,人类和ChatGPT的差异就会变小。

如此看来,语言环境对认知模式的影响,不管是对人还是对AI,都是存在的。

打破三大认知误区:LLM不是只会“抄作业”

这个研究最有价值的地方,其实是它颠覆了几个常见的误区,先说说对认知科学的影响吧。

以前大家总觉得,人类处理语言的能力是独一份的,AI再厉害也学不会这种“独特性”。

但这次研究证明,AI能形成和人类相似的结构化认知,这不是说人类的认知不特别了,而是帮我们找到了语言认知的“共性规律”说不定不管是生物大脑还是人工神经网络,处理语言都需要遵循某些相同的底层逻辑。

对人工智能领域来说,它更是给之前的争议来了个“破局”。

一直有人说LLM只会“模式匹配”,就像抄作业一样,把数据里的搭配复述一遍,根本不懂语言的意思。

但这个研究里,实验结果没法用“只看单词属性和位置”来解释。

很显然,ChatGPT已经能自己抓出语言里的抽象规则,不是单纯靠统计数据混日子。

还有语言学领域,这个研究也给“句法结构普遍性”的理论添了实锤。

以前语言学界就有人说,所有语言都有底层的共性结构,这次人类和AI在不同语言里都表现出相似的句法处理方式,等于是从跨“物种”的角度印证了这个说法。

尤其是对第二语言学习者来说,研究还发现他们的认知模式介于母语者和AI之间这说不定能帮我们搞清楚,学外语的时候为啥总容易混淆语法规则。

不过,我得修正一下自己的说法:这个研究也不是万能的。

它主要聚焦在“句法”层面,也就是句子的结构。

至于更复杂的语义理解比如怎么懂隐喻、怎么分辨歧义句,还有创造性的语言生成比如写诗歌、编故事,AI和人类的差距还没测呢。

所以不能说LLM已经完全“懂”语言了,只能说它在句法这个关键环节,跟上了人类的脚步,接下来再说说这个研究的实际用处。

对AI模型优化来说,以后再改进LLM,就有了明确的方向比如强化句法结构的建模,这样AI写东西的时候,就不容易出现语义歧义。

比如“我打了小明的爸爸”,以前AI可能分不清是“帮小明打爸爸”还是“打了小明的爸爸本人”,要是按这个研究的思路优化,这类错误说不定能少很多。

教育领域也能沾光,比如教第二语言的时候,我们可以对比学生和AI的删词策略要是学生总在时态上出错,就知道得重点补时态;要是总漏了介词短语,就针对性练介词。

这样比盲目刷题要高效得多,还有语言障碍的诊断,以后说不定能靠AI当“辅助工具”。

比如失语症患者,他们处理语言的模式可能会混乱,要是把他们的删词结果和正常人群、AI的结果对比,就能更快找到问题所在。

无奈之下,现在很多语言障碍诊断还靠医生主观判断,有了AI的辅助,准确性说不定能提上来。

至于未来的研究方向,我觉得有几个点得重点挖。

第一个是语义和创造性句法只是基础,真正的语言理解还得看语义,AI能不能像人一样懂“言外之意”,能不能写出有情感的文字,这些都得接着测。

第二个是不同规模的LLM有没有差异现在只测了ChatGPT,小参数模型和大参数模型的认知模式会不会不一样?这对模型设计很重要。

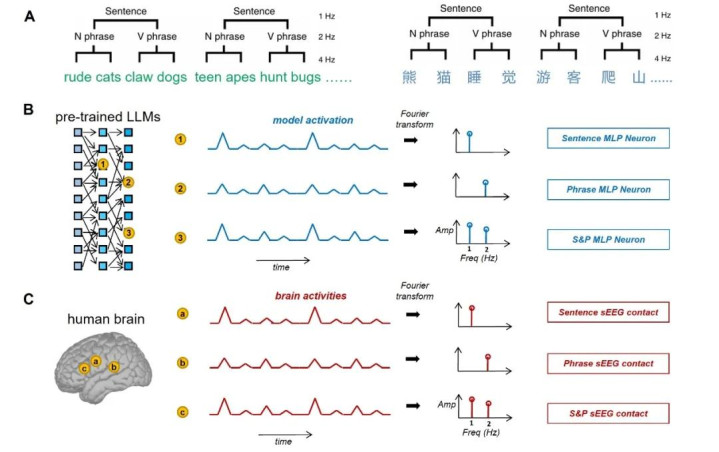

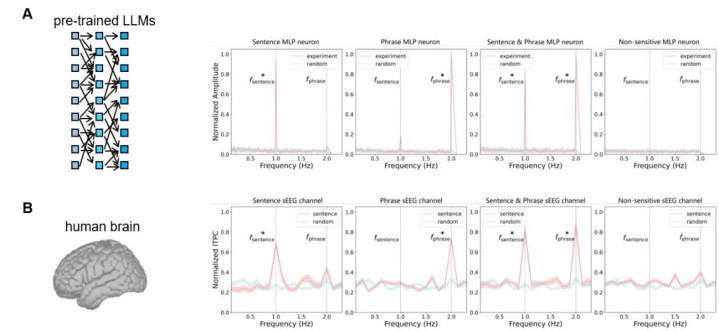

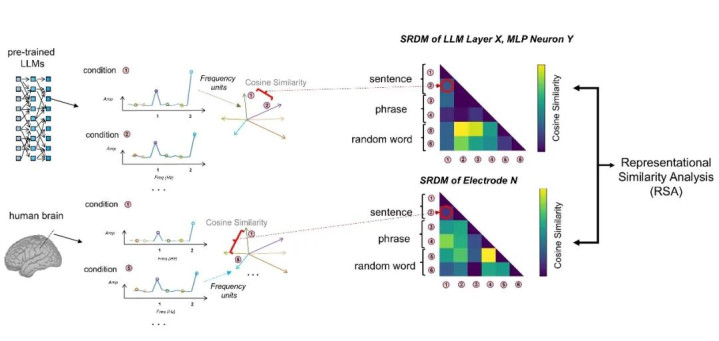

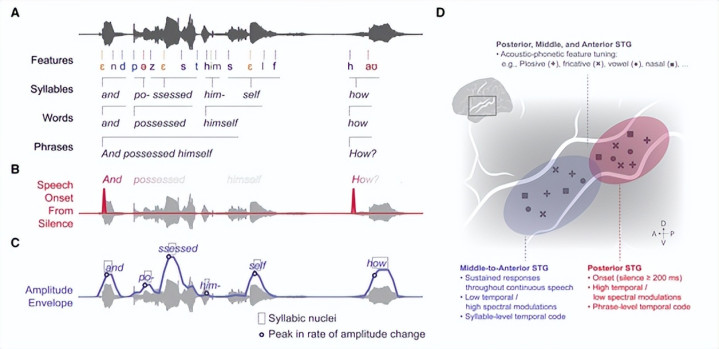

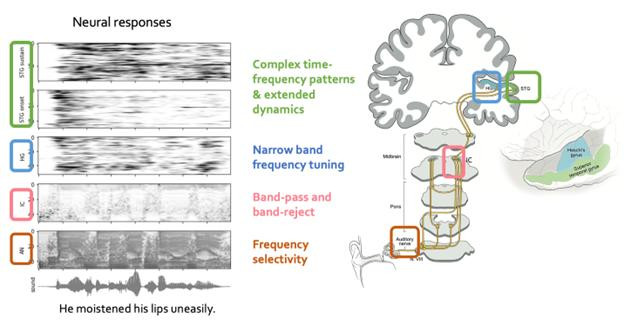

第三个是结合脑科学比如用fMRI看看人处理语言时哪个脑区在动,再对比AI的神经网络激活,说不定能搞懂为啥两者会有相似的认知模式。

如此看来,这个研究不只是发了一篇论文,更像是给认知科学、AI和语言学搭了座桥。

以后我们研究人类的语言认知,可以参考AI的表现;改进AI的时候,又能借鉴人类的认知规律。